EU AI Act: Was Versicherer jetzt wissen müssen

Der EU AI Act konfrontiert Versicherer mit komplexen Anforderungen. Viele Vorgaben sind technisch und organisatorisch anspruchsvoll und erfordern eine sorgfältige Vorbereitung. Deshalb sollten sie das Thema frühzeitig und strukturiert angehen, rät Elischa Göttmann, Principal Solutions Consultant bei Pegasystems.

- EU AI Act: Was Versicherer jetzt wissen müssen

- Wer ist Betreiber und wer Anbieter?

- Was bedeutet der AI Act für den Datenschutz?

Die Europäische Union setzt mit dem AI Act einen umfassenden Rahmen für den Einsatz von Künstlicher Intelligenz. Das Ziel dieses KI-Gesetzes ist, Risiken für Grundrechte, Sicherheit und den Zugang zu essenziellen Dienstleistungen zu minimieren, ohne Innovation zu verhindern. Mit welchen Anforderungen werden Versicherungen dadurch konfrontiert? Welche Maßnahmen müssen sie ergreifen?

Anzeige

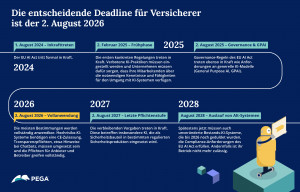

Erste Regelungen des EU AI Act gelten schon, der für Versicherungen relevanteste Teil wird aber im August 2026 in Kraft treten. Viele Versicherer haben bereits KI-Systeme im Einsatz, führen derzeit neue Systeme ein oder planen ihre Implementierung. Um AI-Act-Compliance herzustellen, können umfassende Maßnahmen erforderlich werden, deshalb sollten sie das Thema nicht aufschieben – zumal bei Verstößen empfindliche Geldbußen drohen.

Was versteht der AI Act unter KI?

Um zu verstehen, wie sich Versicherungsunternehmen am besten auf die Deadline im August 2026 vorbereiten, ist es nötig, sich die zentralen Grundlagen des Gesetzeswerks vor Augen zu führen.

Als KI-System definiert der AI Act „ein maschinengestütztes System, das für einen in gewissem Grade autonomen Betrieb ausgelegt ist und nach seiner Betriebsaufnahme Anpassungsfähigkeit zeigen kann. Es verarbeitet Eingaben, um für explizite oder implizite Ziele Ausgaben wie Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen zu erzeugen, die physische oder virtuelle Umgebungen beeinflussen können.“

Zusätzlich definiert der AI Act als eigene Kategorie die so genannte General Purpose AI (GPAI). Darunter versteht er ein KI-System, das für eine Vielzahl von Zwecken entwickelt wurde und nicht auf einen spezifischen Anwendungsfall beschränkt ist. Ein Beispiel dafür ist ein großes Sprachmodell (Large Language Model, LLM), das sowohl für Chatbots als auch für Textanalyse und Code-Generierung genutzt werden kann.

Welchen Pflichten Versicherer bei KI-Systemen und GPAI unterliegen, hängt im Wesentlichen von zwei Faktoren ab. Erstens kommt es darauf an, zu welchem Zweck KI-Systeme eingesetzt werden und dabei insbesondere, ob sie in die Kategorie der Hochrisiko-Systeme fallen; beziehungsweise bei GPAI, ob sie Bestandteil eines Hochrisiko-Systems ist. Zweitens ist entscheidend, ob Versicherer in der Rolle eines Betreibers oder eines Anbieters agieren.

Welche Risikoklassen gibt es?

KI-Systeme, die nicht in die GPAI-Kategorie fallen, unterteilt der AI Act in vier Risikoklassen. Das Kriterium für die Einteilung ist dabei ausschließlich der Einsatzzweck und nicht die Technologie. Ein und dieselbe KI-Architektur kann in unterschiedliche Risikoklassen fallen, je nachdem, wofür sie eingesetzt wird und völlig unabhängig davon, wie „einfach“ oder „komplex“ sie ist.

Schlagzeilen

Warum KI-Projekte bei Versicherern scheitern

Warum digitale Resilienz kein reines IT-Thema ist

Wie Versicherungen mit Agentic AI ihren finanziellen Erfolg nachhaltig absichern

Top-Bonitäts-Staatsanleihen können Portfolios stabilisieren

Krankenkassen mit exzellenter „Kundenberatung“: Die Besten im Online-Echo

- KI-Systeme mit unzulässigem Risiko sind vom AI Act verboten. Dazu zählen beispielsweise Systeme für Social Scoring oder manipulative KI.

- Als Hochrisiko-Systeme sind KI-Anwendungen eingestuft, die direkt Grundrechte, Gesundheit, Sicherheit oder den Zugang zu lebenswichtigen Leistungen beeinflussen. Dazu zählt etwa eine Anwendung, die über die Annahme einer Lebensversicherung entscheidet, ein KI-Modell, das Prämien kalkuliert oder ein System, das Schadensansprüche bewertet. An Hochrisiko-Systeme stellt der AI Act die höchsten Anforderungen.

- Als Systeme mit begrenztem Risiko stuft das Gesetzeswerk Anwendungen ein, die nicht zu den Hochrisiko-Systemen zählen, bei denen Nutzer aber wissen müssen, dass sie mit einer KI interagieren. Sie unterliegen deshalb vor allem Transparenzpflichten. Versicherer müssen es beispielweise gegenüber Kunden offenlegen, wenn diese mit einem Chatbot interagieren.

- Systeme mit minimalem oder ohne Risiko sind für den AI Act Anwendungen, die praktisch keinerlei Gefahr für die Rechte oder Sicherheit von Menschen darstellen. Dazu zählen etwa einfache Empfehlungssysteme für Versicherungsprodukte. Sie können weitgehend ohne regulatorische Einschränkungen eingesetzt werden.

Wer ist Betreiber und wer Anbieter?

Neben KI-Systemen und GPAI sowie verschiedenen Risikoklassen unterscheidet der AI Act auch zwischen Anbietern und Betreibern.

Als Betreiber (Deployer) gilt jede natürliche oder juristische Person, die ein KI-System in eigener Verantwortung verwendet. Beispiele aus dem Versicherungsumfeld sind etwa die Nutzung eines externen KI-Algorithmus zur Betrugserkennung im Alltagsgeschäft oder der Einsatz eines SaaS-KI-Tools für Risikoprüfung oder Pricing.

Anzeige

Als Anbieter (Provider) definiert das Gesetzeswerk jede natürliche oder juristische Person, die ein KI-System entwickelt oder entwickeln lässt und es in Verkehr bringt oder in Betrieb nimmt. Versicherer sind beispielsweise Anbieter, wenn sie einen KI-Schadenklassifizierer selbst entwickeln, einen Dienstleister mit der Entwicklung und anschließenden Bereitstellung des Schadenklassifizierers für den Markt oder den Eigengebrauch beauftragen, oder ein KI-Modell mit allgemeinem Verwendungszweck bereitstellen.

Diese beiden Rollen sind zwar klar definiert, die Grenze ist aber dynamisch. Ein Betreiber kann zum Anbieter werden, wenn er wesentliche Änderungen an einem KI-System vornimmt oder die Zweckbestimmung verändert. Lizenziert ein Versicherer ein KI-System für Risikoprüfung, ist er in der Betreiberrolle. Passt er die Logik des Systems für die Risikoprüfung an, wird er zum Anbieter des modifizierten Systems.

Was gilt für Betreiber und was für Anbieter?

Die Pflichten von Betreibern und Anbietern unterscheiden sich erheblich. Das gilt insbesondere bei Hochrisiko-Systemen. Betreiber von Hochrisiko-Systemen sind verpflichtet, vor dem Einsatz eine Grundrechte-Folgenabschätzung (FRIA) durchzuführen, wenn das System für essenzielle private Dienste (wie Versicherungen) eingesetzt wird. Zudem müssen Betreiber Hochrisiko-Systeme gemäß der Anleitung das Anbieters verwenden und die Nutzung protokollieren sowie nachvollziehbar gestalten. Darüber hinaus müssen sie ihre Mitarbeiter für den sicheren Einsatz schulen, im Betrieb menschliche Aufsicht sicherstellen, das System monitoren und Vorfälle an Anbieter und Behörden melden.

Anbieter müssen vor dem Inverkehrbringen eines Hochrisiko-Systems eine CE-Konformitätsbewertung durchführen. Mit einen formalen Prüfprozess müssen sie sicherstellten, dass ihre Hochrisiko-System alle gesetzlichen Anforderungen erfüllt. Diese Bewertung ist gewissermaßen die CE-Zertifizierung, wie man sie von Elektrogeräten, Maschinen oder Spielwaren kennt, für Künstliche Intelligenz.

Dazu sind die Anbieter verpflichtet, eine technische Dokumentation zu erstellen und ein Risikomanagementsystem aufzusetzen. Sie müssen die Qualität der Trainings-, Validierungs- und Testdaten sicherstellen und das System in einer EU-Datenbank registrieren. Darüber hinaus sind ein Post-Market-Monitoring und die Meldung schwerwiegender Vorfälle erforderlich. Anbieter müssen außerdem kennzeichnen, dass in ihrem System KI im Einsatz ist und eine menschliche Aufsicht des Systems ermöglichen.

Wenn eine GPAI als Komponente in einem Hochrisiko-System eingesetzt wird, unterscheiden sich die Pflichten zwischen Betreiber und Anbieter der GPAI ebenfalls. So müssen Betreiber – basierend auf der Anbieter-Dokumentation – die Risken des GPAI-Modells bewerten und zusätzliche Kontrollen implementieren, um die Hochrisiko-Anforderungen zu erfüllen. Zudem sind sie verpflichtet, ein eigenes Risikomanagement aufzusetzen, da GPAI meist generisch ist. Anbieter müssen ihre Systemdokumentation offenlegen, ihre Trainingsdatenkategorien beschreiben und ihre GPAI in eine EU-Datenbank eintragen. Zudem müssen sie Risikominderungspflichten für generische Anwendungen nachkommen.

Zusammenfassend lässt sich sagen: Der Anbieter trägt die Hauptlast. Er ist für Entwicklung, Zertifizierung und Registrierung zuständig, während der Betreiber lediglich operative Pflichten hat. Bei GPAI ist die Verantwortung verteilt: Der Betreiber muss sicherstellen, dass er die vom Anbieter bereitgestellten Informationen korrekt nutzt. Versicherer sollten eine klare Governance etablieren, um einen ungewollten Rollenwechsel zu vermeiden.

Was bedeutet der AI Act für den Datenschutz?

Besonderes Augenmerk müssen Versicherer auch auf den Datenschutz legen. Der AI Act ergänzt die DSGVO, aber ersetzt sie nicht. Jeder Verarbeitung von personenbezogenen Daten mit KI-Systemen muss den DSGVO-Prinzipien entsprechen (Rechtmäßigkeit, Zweckbindung, Datenminimierung, Transparenz, Sicherheit). Der AI Act fügt diesen Anforderung weitere Datenschutz-Pflichten hinzu.

Möchte ein Versicherer beispielsweise ein KI-Modell für Schadenklassifizierung mit Kundendaten trainieren, verlangt der AI Act zusätzlich von ihm, dass die Trainingsdaten repräsentativ und frei von Bias sind. Zudem muss er die Quellen und die Qualität der Daten dokumentieren. Wenn ein Versicherer Kundendaten mit einem Hochrisiko-System verarbeiten will, etwa einer Anwendung für Risikoprüfung oder Pricing, muss er dafür sorgen, dass das System keine diskriminierenden Ergebnisse nach sensiblen Merkmalen produziert.

Zusätzliche Datenschutz-Anforderungen ergeben sich auch beim Einsatz von GPAI. Möchte ein Versicherer beispielsweise für einen Chatbot eine GPAI in Kombination mit Kundendaten nutzen, muss er prüfen, ob der Anbieter der GPAI diese Daten für das Weitertraining seines Modells nutzt und sich dann gegebenenfalls die Einwilligung seiner Kunden einholen. Nicht zuletzt ist er auch dafür verantwortlich, dass die Integration der GPAI keine Risiken wie Datenlecks erzeugt.

Wie gehen Versicherer am besten vor?

Die ersten Regelungen des AI Act sind bereits in Kraft. So dürfen inzwischen beispielsweise keine verbotenen KI-Systeme mehr eingesetzt werden. Die entscheidende Deadline für KI im Versicherungsbetrieb ist aber der 2. August 2026. Ab diesem Tag werden die meisten Bestimmungen anwendbar: Hochrisiko-Systeme benötigen die CE-Kennzeichnung und die Transparenzpflichten beispielsweise bei Chatbots müssen umgesetzt sein. Die Anbieter- und Betreiberpflichten greifen vollständig.

Die vielen unterschiedlichen Anforderungen des AI Act machen es notwendig, dass Versicherer sehr genau prüfen, welche davon für ihre KI-Systeme gelten. Folgender Fahrplan kann ihnen dabei helfen, Compliance herzustellen:

- KI-Inventar erstellen. Die Erfassung aller KI-Systeme inklusive Zweck und Version ist eine gute Ausgangsbasis.

- Rollen und Risiken klären. Anschließend können Versicherer für jedes System die eigene Rolle klären (Anbieter/Betreiber) und Hochrisiko-Anwendungen priorisieren.

- Gap-Analyse durchführen. Um zu ermitteln, welche konkreten Maßnahmen erforderlich sind, sollte geprüft werden, ob für die Systeme alle Pflichten erfüllt sind (Dokumentation, menschliche Aufsicht, Transparenz) beziehungsweise wo es noch Lücken gibt.

- Lücken schließen. Auf Basis der Gap-Analyse können Versicherer dann gezielt tätig werden. Wenn erforderlich, müssen fehlende Dokumentationen und ein fehlendes Risikomanagement aufgesetzt werden. Zudem sollten sie Prozesse für Incident-Meldungen und die CE-Kennzeichnung einführen.

- Governance und Verträge anpassen. Am besten legen Versicherungen in Rollenswitch-Klauseln fest, was passiert, wenn sie durch Anpassungen an KI-Systemen zu Anbietern werden. Die Klauseln sollten klare Verantwortlichkeiten und Pflichten festlegen. Von Anbietern externer Systeme sollten sie sich vertraglich garantieren lassen, dass sie alle AI-Act-Pflichten erfüllen und Änderungen melden. Nicht zuletzt müssen sie KI-Governance in ihre Compliance-Strukturen integrieren und ihr Management entsprechend schulen.

Der AI Act markiert für Versicherer einen Wendepunkt, der weit über technische Anpassungen hinausgeht. Wer die Anforderungen frühzeitig adressiert, schafft nicht nur Rechtssicherheit, sondern legt auch die Basis für vertrauenswürdige KI – und stärkt damit seine Reputation besonders im sensiblen Versicherungsumfeld.

Schlagzeilen

Spahn erwartet steigendes Renteneintrittsalter und bringt höhere Erwerbsminderungsrente ins Spiel

Gehaltscheck: Einstiegsgehälter in der Versicherungsbranche

Was entsteht, wenn man Notfallplanung einmal aus Kinderaugen betrachtet?

Gesetzliche Krankenkassen: Freiwillige Kassenleistungen auf dem Prüfstand

Umwelthaftpflichtversicherung und Klimakrise: Systemische Risiken im Versicherungsmodell

- EU AI Act: Was Versicherer jetzt wissen müssen

- Wer ist Betreiber und wer Anbieter?

- Was bedeutet der AI Act für den Datenschutz?